專題簡介

研究目的

隨著高齡化問題逐漸嚴峻,台灣的人口結構正面臨重大變革。據內政部統計,截至2022年,65歲以上老年人口占比已達15.5%,預估到2030年將增至20.3%,而在2070年更預計達到39.3%。國家發展委員會的研究顯示,2022年台灣65歲以上老年人將達300萬人,預計到2030年將增至430萬人,並在未來數十年持續增長。高齡化問題對社會帶來的挑戰和影響不容忽視。為因應人口老化和長照需求,我們致力於研發一款創新的日照聊天機器人。這款機器人不僅提供家庭和老人安養院更方便、貼心的照顧解決方案,同時我們計畫將其應用於服務高風險的失智族群。透過機器人的對話功能以刺激失智族群的腦部活動,預防失智症的發生。我們的目標客群包括已有初期失智症狀的老年人,以及有家族遺傳風險的人群。透過與聊天機器人的互動,這些高風險族群可以保持社交聯繫、刺激大腦和思考能力,以預防失智症的發生。透過高度技術化的日照聊天機器人,我們期待為社會的高齡化問題提供更具創新性和便捷性的解決方案。

系統特色

- 使用者可以自行創造擁有不同聲音、年齡和性格的客製化角色。

- 透過語音合成技術,iCare日照聊天機器人能夠模擬人類的語音和語調,並在不同的對話場景和對象中進行適應。

- 利用生成式AI技術,使機器人具備自我學習和不斷進化的能力,實現個性化對話,以提供更貼近使用者習慣的對話體驗。

- 引入臉部影像辨識技術,偵測使用者的表情並提供給語言模型,使機器人能夠根據使用者的情緒生成更具真實感的回應,達到更佳貼近真人對話的效果。

研究流程與方法

研究步驟

A. 選擇角色: 使用者從已創建的多名角色中選擇欲對話的對象。 角色資料匯入: 選擇角色後,系統根據選擇的角色建立相應的語音模型和外貌特徵。

B. 進行對話(核心機制): 使用者與選擇的角色開始對話。

C. 表情辨識: 攝影機同步辨識使用者表情,將表情標籤加入核心機制。

D. 對話內容儲存: 系統將使用者與機器人的對話內容儲存至資料庫,紀錄互動歷史。

E. 判斷對話是否結束: 系統判斷對話是否結束。若使用者無回應,則視為對話結束。

F. 對話結束: 若對話結束,流程結束;反之,回到核心機制生成回應。

G. 結束: 完成對話互動,流程結束。

在使用者回應後進入核心機制。核心機制首先將使用者的語音內容轉換成文字並同時進行表情辨識,分析使用者情緒。接著將對話文字及情緒等資料傳遞至GPT3.5模型生成回應。最後,以事先訓練的VITS模型將回應文字轉換成角色語音並輸出。

互動逾時機制會在系統輸出回應且使用者在十秒內無回應時啟動。啟動時系統會先開啟新話題,並等待交談者回應。若交談者回應則返回對話,無回應則進入待機狀態。

VITS原理

透過Text Encoder取得文本分布的特徵,優化VAE的變分條件下界。為了給後編碼器提供更高分辨率的信息,使用線性譜而非梅爾頻譜作為後編碼器的輸入。同時,為了生成更加逼真的樣本,發現提高前編碼器分布的表達能力比較重要,因此引入標準化流,在文本編碼器產生的簡單分布和複雜分布間進行可逆變換。也就是說,在經過前編碼器採樣輸出之後,加入一系列可逆變換。

VITS訓練

實際操作時採用的是現時大多研究者會使用的方式,該方式的優點為快速且效果不錯。具體方法為先在訓練模型前嵌入一個包含大量聲音樣本的底模,使模型在訓練時節省大量時間。

GPT3.5模型

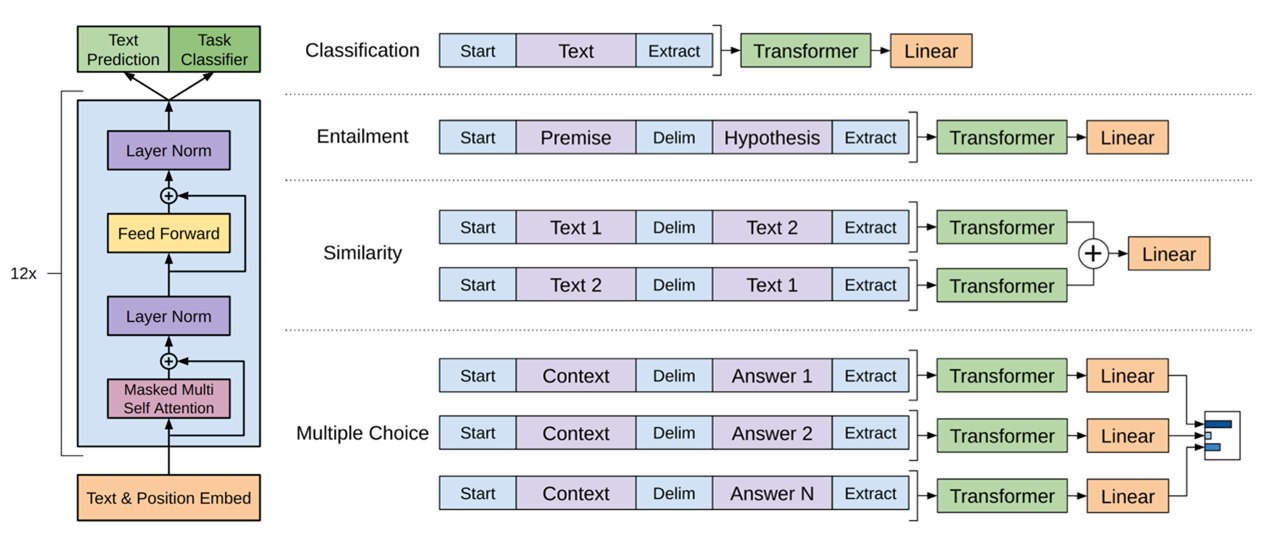

GPT-3.5是一種專為對話設計的自然語言生成模型,它基於Transformer架構,結合了預訓練和微調兩個重要階段,分別構建了預訓練模型架構和微調模型架構。

上圖左側部分是預訓練模型架構,其中採用了Transformer架構。Transformer是一種基於自注意機制的深度學習模型,它能夠處理序列數據,特別適用於自然語言處理任務。GPT-3.5的預訓練階段通過大規模的文本數據訓練,使得模型能夠學習到豐富的語言表示。

右側部分涵蓋了GPT-3.5的微調模型架構,主要應用在文本分類(Classification)、藴涵(Entailment)、相似度(Similarity)和多選擇問題(Multiple Choice)等任務上。這個階段的微調旨在針對具體任務進行模型優化,提高性能和準確性。

GPT3.5模型特點和優勢:

GPT-3.5以其龐大的參數量和強大的上下文理解能力而聞名。由於預訓練階段的深度學習,模型能夠捕捉到語言的語義結構和語境信息,使得在特定任務上取得出色的表現成為可能。在微調階段,模型進一步精煉以應對具體的應用場景,從而在文本分類、蕴涵判斷、相似度比較和多選擇問題等多樣任務上展現卓越的適應性和泛化能力。

相關應用

- VITS 單純的TTS(Text-To-Speech),也就是文字轉語音,一般大約3分鐘左右的純淨資料就能得到效果不錯的模型。

- So-VITS-SVC(Singing Voice Conversion) 一種基於神經網路的聲音轉換方法,通常使用變分自動編碼器(Variational Autoencoder,VAE)或其他神經網路架構。專注於歌聲轉換,目標是將輸入聲音樣本轉換成具有不同特徵的歌聲,例如將男性的聲音轉換成女性的聲音,或者改變歌聲的音調和音樂特徵,與VITS模型不通用。

- RVC(Retrieval-based Voice Conversion) RVC是一種基於檢索的聲音轉換方法,通常使用大規模的語音資料庫。它從中檢索與輸入語音相似的聲音樣本,並在保留聲音特徵的前提下,將輸入語音轉換成與檢索到的聲音相似的聲音。雖可用於歌聲轉換,但在這方面通常不如專門設計的方法(如So-VITS-SVC)表現出色。 RVC的優勢在於能夠利用大數據庫實現高效的聲音轉換,特別適用於語音相似性的保持。

在權衡三者優劣後我們團隊決定使用VITS模型,原因在於該模型的通用性最佳,並且純粹的TTS已足夠滿足我們的需求與標準。SoVITS雖是VITS的改良版,多了歌唱的功能,但礙於其模型通用性較低,所以沒有採用。至於RVC則是因為其更像是一個變聲器,而不是語音模型,在我們專題上能應用的範圍較小。

實驗結果

- 讀取到使用者說話,程式做出回應

- 若使用者一段時間沒說話,程式也會主動尋找話題